最近一个客户网站出现了很奇怪的现象 网站之前还是可以收录的 但是突然之前网站停止收录了 。最后查看到的问题是:

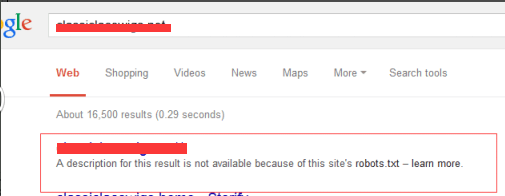

提示 robots.txt 有问题 。robots.txt的文件对于网站的优化和收录还是很有好处的

1.、屏蔽网站内的死链接。

2、屏蔽谷歌收取重复的页面

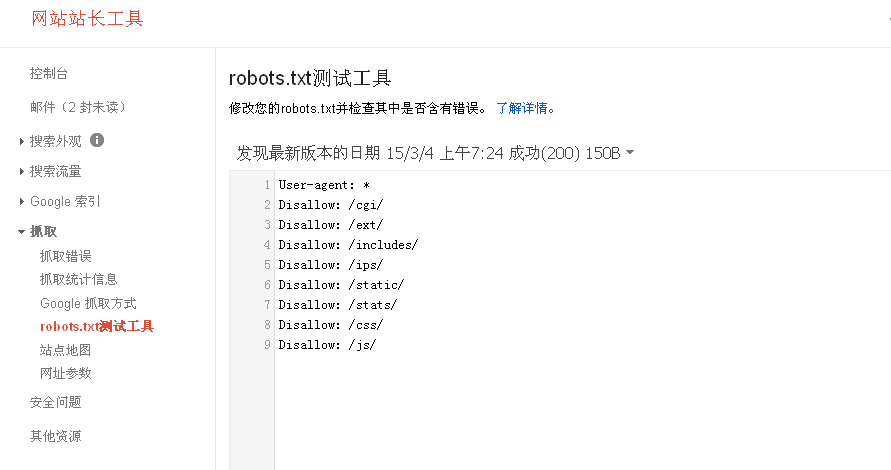

打开robots.txt 发现了 User-agent:*Disallow这句话、他屏蔽了所有搜索引擎访问网站所以完整没有被谷歌收录

知道问题了 直接在谷歌站长工具上生成一个最新的robots.txt 然后上传 。

最后在向谷歌提交一下 。